Platform TensorFlow Google memungkinkan penggunanya untuk melatih AI dengan menyediakan alat dan sumber daya untuk pembelajaran mesin.Untuk waktu yang lama, insinyur AI telah menggunakan CPU dan GPU tradisional untuk melatih AI.Meskipun prosesor ini dapat menangani berbagai proses pembelajaran mesin, mereka masih merupakan perangkat keras serba guna yang digunakan untuk berbagai tugas sehari-hari.

Untuk mempercepat pelatihan AI, Google mengembangkan Application Specific Integrated Circuit (ASIC) yang dikenal sebagai Tensor Processing Unit (TPU).Tapi, apa itu Unit Pemrosesan Tensor, dan bagaimana mereka mempercepat pemrograman AI?

Daftar isi

Apa itu Tensor Processing Unit (TPU)?

Unit Pemrosesan Tensor adalah ASIC Google untuk pembelajaran mesin.TPU secara khusus digunakan untuk pembelajaran mendalam untuk menyelesaikan operasi matriks dan vektor yang kompleks.TPU disederhanakan untuk menyelesaikan operasi matriks dan vektor pada kecepatan sangat tinggi tetapi harus dipasangkan dengan CPU untuk memberikan dan menjalankan instruksi.TPU hanya dapat digunakan dengan platform TensorFlow atau TensorFlow Lite Google, baik melalui komputasi awan atau versi ringannya di perangkat keras lokal.

Aplikasi untuk TPU

Kredit Gambar: Element5 Digital/ Unsplash

Kredit Gambar: Element5 Digital/ Unsplash

Google telah menggunakan TPU sejak 2015. Mereka juga telah mengkonfirmasi penggunaan prosesor baru ini untuk pemrosesan teks Google Street View, Google Foto, dan Hasil Pencarian Google (Peringkat Otak), serta untuk membuat AI yang dikenal sebagai AlphaGo,yang telah mengalahkan pemain Go teratas dan sistem AlphaZero yang menang melawan program terkemuka di Catur, Go, dan Shogi.

TPU dapat digunakan dalam berbagai aplikasi pembelajaran mendalam seperti deteksi penipuan, visi komputer, pemrosesan bahasa alami, mobil yang dapat mengemudi sendiri, AI vokal, pertanian, asisten virtual, perdagangan saham, e-niaga, dan berbagai prediksi sosial.

Kapan Menggunakan TPU

Karena TPU adalah perangkat keras khusus yang tinggi untuk pembelajaran mendalam, TPU kehilangan banyak fungsi lain yang biasanya Anda harapkan dari prosesor tujuan umum seperti CPU.Dengan mengingat hal ini, ada skenario khusus di mana penggunaan TPU akan memberikan hasil terbaik saat melatih AI.

Waktu terbaik untuk menggunakan TPU adalah untuk operasi di mana model sangat bergantung pada perhitungan matriks, seperti sistem rekomendasi untuk mesin telusur.TPU juga memberikan hasil yang luar biasa untuk model di mana AI menganalisis sejumlah besar titik data yang akan membutuhkan waktu beberapa minggu atau bulan untuk menyelesaikannya.Insinyur AI menggunakan TPU untuk instans tanpa model TensorFlow kustom dan harus memulai dari awal.

Kapan Tidak Menggunakan TPU

Seperti yang dinyatakan sebelumnya, pengoptimalan TPU menyebabkan jenis prosesor ini hanya bekerja pada operasi beban kerja tertentu.Oleh karena itu, ada beberapa contoh di mana memilih untuk menggunakan CPU dan GPU tradisional akan memberikan hasil yang lebih cepat.Contoh ini meliputi:

- Pembuatan prototipe cepat dengan fleksibilitas maksimum

- Model dibatasi oleh titik data yang tersedia

- Model yang sederhana dan dapat dilatih dengan cepat

- Model jugasulit untuk diubah

- Model yang bergantung pada operasi TensorFlow khusus yang ditulis dalam C++

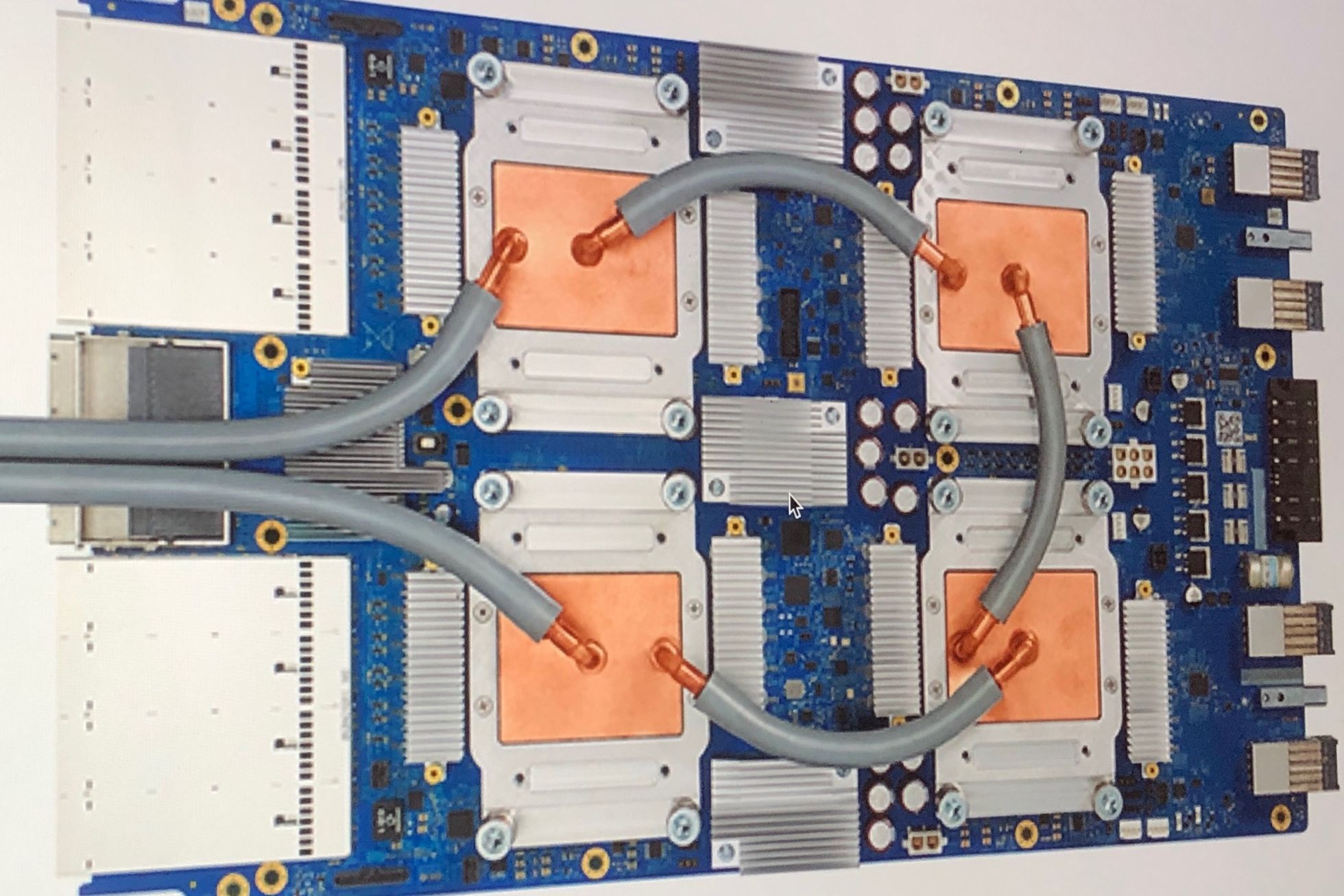

Versi dan Spesifikasi TPU

Kredit Gambar:Zinskauf/ Wikimedia Commons

Kredit Gambar:Zinskauf/ Wikimedia Commons

Sejak Google mengumumkan TPU-nya, publik terus diperbarui tentang versi terbaru TPU dan spesifikasinya.Berikut ini adalah daftar semua versi TPU dengan spesifikasi:

TPUv1 TPUv2 TPUv3 TPUv4 Edgev1

| Tanggal Diperkenalkan | 2016 | 2017 | 2018 | 2021 | 2018 |

| Proses node(nm) | 28 | 16 | 16 | 7 | |

| Ukuran cetakan (mm²) | 331 | <625 | <700 | <400 | |

| Memori Dalam Chip | 28 | 32 | 32 | 144 | |

| Kecepatan Jam (MHz) | 700 | 700 | 940 | 1050 | |

| Konfigurasi Memori (GB) Terkecil | 8 DDR3 | 16 HBM | 32 HBM | 32 HBM | |

| TDP (Watt) | 75 | 280 | 450 | 175 | 2 |

| TOPS (Tera Operasi Per Detik) | 23 | 45 | 90 | ? | 4 |

| TOPS/W | 0,3 | 0,16 | 0,2 | ? | 2 |

Seperti yang Anda lihat, kecepatan clock TPU tampaknya tidak terlalu mengesankan, terutama ketika komputer desktop modern saat ini dapat memiliki kecepatan clock 3-5 kali lebih cepat.Tetapi jika Anda melihat dua baris bawah tabel, Anda dapat melihat bahwa TPU dapat memproses 23-90 tera-operasi per detik hanya dengan menggunakan daya 0,16—0,3 watt.TPU diperkirakan 15-30 kali lebih cepat daripada CPU dan GPU modern saat menggunakan antarmuka jaringan saraf.

Dengan setiap versi yang dirilis, TPU yang lebih baru menunjukkan peningkatan dan kemampuan yang signifikan.Berikut adalah beberapa sorotan untuk setiap versi.

- TPUv1: TPU pertama yang diumumkan secara publik.Dirancang sebagai mesin perkalian matriks 8-bit dan terbatas hanya untuk memecahkan bilangan bulat.

- TPUv2: Karena para insinyur mencatat bahwa bandwidth TPUv1 terbatas.Versi ini sekarang memiliki dua kali lipat bandwidth memori dengan 16GB RAM.Versi ini sekarang dapat memecahkan floating point sehingga berguna untuk pelatihan dan inferensi.

- TPUv3: Dirilis pada tahun 2018, TPUv3 memiliki prosesor dua kali lipat dan digunakan dengan chip empat kali lebih banyak daripada TPUv2.Pembaruan memungkinkan versi ini memiliki kinerja delapan kali lipat dari versi sebelumnya.

- TPUv4: Ini adalah versi terbaru dari TPU yang diumumkan pada 18 Mei 2021. CEO Google mengumumkan bahwa versi ini akan memiliki lebih dari dua kali kinerja TPU v3.

- Edge TPU: Versi TPU ini dimaksudkan untuk operasi yang lebih kecil yang dioptimalkan untuk menggunakan lebih sedikit daya daripada versi TPU lainnya dalam operasi keseluruhan.Meski hanya menggunakan daya dua watt, Edge TPU dapat menyelesaikan hingga empat operasi terra per detik.Edge TPU hanya ditemukan pada perangkat genggam kecil seperti smartphone Pixel 4 Google.

Bagaimana Anda Mengakses TPU?Siapa yang Dapat Menggunakannya?

TPU adalah unit pemrosesan eksklusif yang dirancang oleh Google untuk digunakan dengan platform TensorFlow-nya.Akses pihak ketiga ke prosesor ini telah diizinkan sejak 2018. Saat ini, TPU (kecuali Edge TPU) hanya dapat diakses melalui layanan komputasi Google melalui cloud.Sementara perangkat keras Edge TPU dapat dibeli melalui smartphone Pixel 4 Google dan kit prototyping-nya yang dikenal sebagai Coral.

Coral adalah akselerator USB yang menggunakan USB 3.0 Tipe C untuk data dan daya.Ini memberi perangkat Anda komputasi Edge TPU yang mampu 4 TOPS untuk setiap 2W daya.Kit ini dapat berjalan pada mesin yang menggunakan Windows 10, macOS, dan Debian Linux (juga dapat bekerja dengan Raspberry Pi).

Akselerator AI Khusus Lainnya

Dengan kecerdasan buatan yang populer selama dekade terakhir, Big Tech terus mencari cara untuk membuat pembelajaran mesin secepat dan seefisien mungkin.Meskipun TPU Google bisa dibilang merupakan ASIC paling populer yang dikembangkan untuk pembelajaran mendalam, perusahaan teknologi lain seperti Intel, Microsoft, Alibaba, dan Qualcomm juga telah mengembangkan akselerator AI mereka sendiri.Ini termasuk Microsoft Brainwave, Intel Neural Compute Stick, dan Graphicore’s IPU (Intelligence Processing Unit).

Tetapi sementara lebih banyak perangkat keras AI sedang dikembangkan, sayangnya, sebagian besar belum tersedia di pasar, dan banyak yang tidak akan pernah tersedia.Pada saat penulisan, jika Anda benar-benar ingin membeli perangkat keras akselerator AI, opsi paling populer adalah membeli kit prototyping Coral, Intel NCS, Graphicore Bow Pod, atau Asus IoT AI Accelerator.Jika Anda hanya ingin akses ke perangkat keras AI khusus, Anda dapat menggunakan layanan komputasi awan Google atau alternatif lain seperti Microsoft Brainwave.