تتيح منصة TensorFlow من Google لمستخدميها تدريب الذكاء الاصطناعي من خلال توفير الأدوات والموارد للتعلم الآلي.لفترة طويلة ، استخدم مهندسو الذكاء الاصطناعي وحدات المعالجة المركزية ووحدات معالجة الرسومات التقليدية لتدريب الذكاء الاصطناعي.على الرغم من أن هذه المعالجات يمكنها التعامل مع العديد من عمليات التعلم الآلي ، إلا أنها لا تزال أجهزة ذات أغراض عامة تُستخدم في مختلف المهام اليومية.

لتسريع تدريب الذكاء الاصطناعي ، طورت Google دائرة متكاملة خاصة بالتطبيق (ASIC) تُعرف باسم وحدة معالجة الموتر (TPU).ولكن ، ما هي وحدة معالجة Tensor ، وكيف تعمل على تسريع برمجة الذكاء الاصطناعي؟

جدول المحتويات

ما المقصود بوحدات معالجة الموتر (TPU)؟

وحدات معالجة الموتر هي ASIC من Google للتعلم الآلي.تُستخدم TPUs على وجه التحديد للتعلم العميق لحل عمليات المصفوفة والمتجهات المعقدة.يتم تبسيط TPUs لحل عمليات المصفوفة والمتجهات بسرعات عالية جدًا ولكن يجب إقرانها بوحدة معالجة مركزية لإعطاء التعليمات وتنفيذها.لا يجوز استخدام TPU إلا مع نظام Google الأساسي TensorFlow أو TensorFlow Lite ، سواء من خلال الحوسبة السحابية أو إصدارها البسيط على الأجهزة المحلية.

تطبيقات لأجهزة TPU

رصيد الصورة: Element5 Digital/Unsplash

رصيد الصورة: Element5 Digital/Unsplash

استخدمت Google وحدات TPU منذ عام 2015. وقد أكدوا أيضًا استخدام هذه المعالجات الجديدة لمعالجة نصوص Google Street View و Google Photos و Google Search Results (Rank Brain) ، وكذلك لإنشاء AI معروف باسم AlphaGo ،التي تغلبت على أفضل لاعبي Go ونظام AlphaZero الذي فاز على البرامج الرائدة في الشطرنج وجو وشوجي.

يمكن استخدام TPU في العديد من تطبيقات التعلم العميق مثل اكتشاف الاحتيال ، ورؤية الكمبيوتر ، ومعالجة اللغة الطبيعية ، والسيارات ذاتية القيادة ، والذكاء الاصطناعي الصوتي ، والزراعة ، والمساعدين الافتراضيين ، وتداول الأسهم ، والتجارة الإلكترونية ، والتنبؤات الاجتماعية المتنوعة.

متى تستخدم TPUs

نظرًا لأن TPU هي أجهزة عالية التخصص للتعلم العميق ، فإنها تفقد الكثير من الوظائف الأخرى التي تتوقعها عادةً من معالج للأغراض العامة مثل وحدة المعالجة المركزية.مع وضع ذلك في الاعتبار ، هناك سيناريوهات محددة حيث سيؤدي استخدام TPUs إلى تحقيق أفضل نتيجة عند تدريب الذكاء الاصطناعي.

أفضل وقت لاستخدام TPU هو للعمليات التي تعتمد فيها النماذج بشكل كبير على حسابات المصفوفة ، مثل أنظمة التوصية لمحركات البحث.تعطي TPUs أيضًا نتائج رائعة للنماذج حيث يحلل الذكاء الاصطناعي كميات هائلة من نقاط البيانات التي ستستغرق عدة أسابيع أو أشهر حتى تكتمل.يستخدم مهندسو الذكاء الاصطناعي TPUs للحالات التي لا تحتوي على نماذج TensorFlow مخصصة ويجب أن تبدأ من نقطة الصفر.

عندما لا تستخدم TPUs

كما ذكرنا سابقًا ، يؤدي تحسين TPUs هذه الأنواع من المعالجات إلى العمل فقط على عمليات أعباء عمل محددة.لذلك ، هناك حالات يؤدي فيها اختيار استخدام وحدة المعالجة المركزية التقليدية ووحدة معالجة الرسومات إلى نتائج أسرع.تشمل هذه الحالات:

- النماذج الأولية السريعة بأقصى قدر من المرونة

- النماذج المقيدة بنقاط البيانات المتاحة

- النماذج البسيطة ويمكن تدريبها بسرعة

- النماذج أيضًامرهقة للتغيير

- النماذج التي تعتمد على عمليات TensorFlow المخصصة والمكتوبة بلغة ++ C

إصدارات ومواصفات TPU

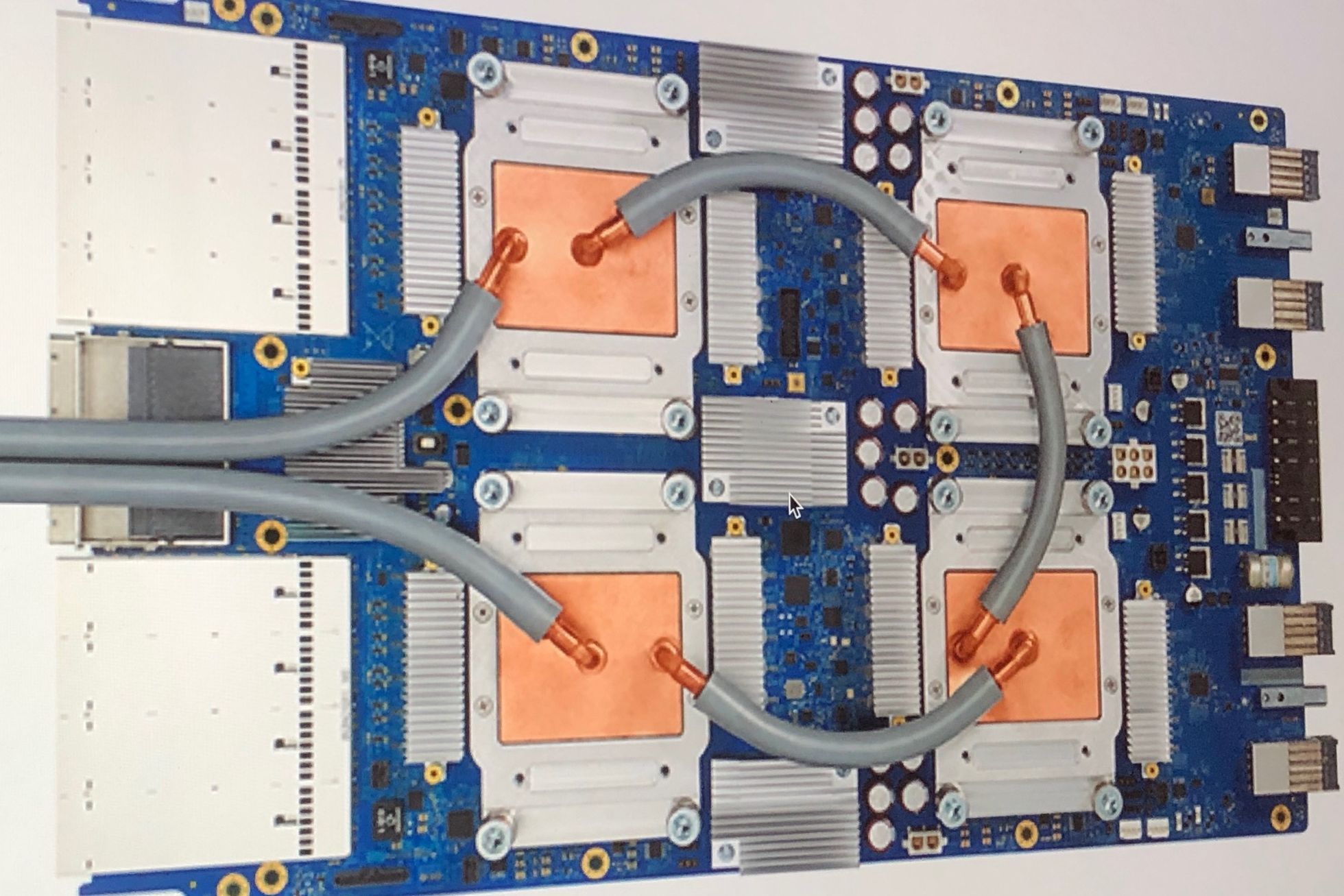

صورة الائتمان: Zinskauf/ويكيميديا كومنز

صورة الائتمان: Zinskauf/ويكيميديا كومنز

منذ أن أعلنت Google عن وحدات TPU الخاصة بها ، تم تحديث الجمهور باستمرار بأحدث إصدارات TPU ومواصفاتها.فيما يلي قائمة بجميع إصدارات TPU مع المواصفات:

TPUv1 TPUv2 TPUv3 TPUv4 Edgev1

| تاريخ التقديم | 2016 | 2017 | 2018 | 2021 | 2018 |

| عقدة العملية(نانومتر) | 28 | 16 | 16 | 7 | |

| حجم القالب (مم²) | 331 | <625 | <700 | <400 | |

| الذاكرة المدمجة | 28 | 32 | 32 | 144 | |

| سرعة الساعة (ميغا هرتز) | 700 | 700 | 940 | 1050 | |

| أصغر تكوين للذاكرة (جيجابايت) | 8 DDR3 | 16 HBM | 32 HBM | 32 HBM | |

| TDP (Watts) | 75 | 280 | 450 | 175 | 2 |

| TOPS (عمليات تيرا في الثانية) | 23 | 45 | 90 | ؟ | 4 |

| TOPS/W | 0.3 | 0.16 | 0.2 | ؟ | 2 |

كما ترى ، لا تبدو سرعات ساعة TPU مثيرة للإعجاب ، خاصةً عندما تتمتع أجهزة الكمبيوتر المكتبية الحديثة اليوم بسرعات أعلى بمقدار 3-5 مرات.ولكن إذا نظرت إلى الصفين السفليين من الجدول ، يمكنك أن ترى أن TPUs يمكنها معالجة 23-90 تيرا-عملية في الثانية باستخدام 0.16 – 0.3 واط فقط من الطاقة.تُقدَّر وحدات TPU بأنها أسرع بـ 15-30 مرة من وحدات المعالجة المركزية (CPU) ووحدات معالجة الرسومات (GPU) الحديثة عند استخدام واجهة الشبكة العصبية.

مع طرح كل إصدار ، تُظهر وحدات TPU الجديدة تحسينات وقدرات كبيرة.فيما يلي بعض النقاط البارزة لكل إصدار.

- TPUv1: أول TPU تم الإعلان عنه علنًا.مصمم كمحرك ضرب مصفوفة 8 بت ويقتصر على حل الأعداد الصحيحة فقط.

- TPUv2: نظرًا لأن المهندسين لاحظوا أن TPUv1 كان محدودًا في النطاق الترددي.يحتوي هذا الإصدار الآن على ضعف عرض النطاق الترددي للذاكرة مع 16 جيجابايت من ذاكرة الوصول العشوائي.يمكن لهذا الإصدار الآن حل النقاط العائمة مما يجعلها مفيدة للتدريب والاستنتاج.

- TPUv3: تم طرحه في 2018 ، يحتوي TPUv3 على ضعف المعالجات ويتم نشره بأربعة أضعاف عدد الرقائق مثل TPUv2.تسمح الترقيات لهذا الإصدار بالحصول على ثمانية أضعاف الأداء مقارنة بالإصدارات السابقة.

- TPUv4: هذا هو أحدث إصدار من TPU تم الإعلان عنه في 18 مايو 2021. أعلن الرئيس التنفيذي لشركة Google أن هذا الإصدار سيكون له أكثر من ضعف أداء TPU v3.

- Edge TPU: تم تصميم إصدار TPU هذا لعمليات أصغر محسّنة لاستخدام طاقة أقل من الإصدارات الأخرى من TPU في التشغيل الكلي.على الرغم من استخدام 2 واط فقط من الطاقة ، يمكن لـ Edge TPU حل ما يصل إلى أربع عمليات تيرا في الثانية.تم العثور على Edge TPU فقط على الأجهزة المحمولة الصغيرة مثل هاتف Pixel 4 الذكي من Google.

كيف يمكنك الوصول إلى TPU؟من يمكنه استخدامها؟

تُعد TPUs وحدات معالجة خاصة تم تصميمها بواسطة Google لاستخدامها مع نظام TensorFlow الخاص بها.تم السماح بوصول الجهات الخارجية إلى هذه المعالجات منذ عام 2018. واليوم ، لا يمكن الوصول إلى TPU (باستثناء Edge TPUs) إلا من خلال خدمات الحوسبة من Google عبر السحابة.بينما يمكن شراء أجهزة Edge TPU من خلال هاتف Pixel 4 الذكي من Google ومجموعة النماذج الأولية المعروفة باسم Coral.

Coral هو مسرع USB يستخدم USB 3.0 Type C للبيانات والطاقة.يوفر لجهازك حوسبة Edge TPU قادرة على 4 TOPS لكل 2W من الطاقة.يمكن تشغيل هذه المجموعة على الأجهزة التي تستخدم Windows 10 و macOS و Debian Linux (يمكنها أيضًا العمل مع Raspberry Pi).

مسرعات الذكاء الاصطناعي المتخصصة الأخرى

مع انتشار الذكاء الاصطناعي في العقد الماضي ، تبحث Big Tech باستمرار عن طرق لجعل التعلم الآلي سريعًا وفعالًا قدر الإمكان.على الرغم من أن TPUs من Google هي أكثر ASIC شيوعًا التي تم تطويرها للتعلم العميق ، فقد طورت شركات التكنولوجيا الأخرى مثل Intel و Microsoft و Alibaba و Qualcomm أيضًا مسرعات الذكاء الاصطناعي الخاصة بها.وتشمل هذه الميزات Microsoft Brainwave و Intel Neural Compute Stick و Graphicore’s IPU (وحدة معالجة الذكاء).

ولكن بينما يتم تطوير المزيد من أجهزة الذكاء الاصطناعي ، للأسف ، لم يتوفر معظمها بعد في السوق ، ولن يتوفر الكثير منها على الإطلاق.اعتبارًا من الكتابة ، إذا كنت تريد حقًا شراء أجهزة تسريع AI ، فإن الخيارات الأكثر شيوعًا هي شراء مجموعة نماذج أولية من Coral أو Intel NCS أو Graphicore Bow Pod أو Asus IoT AI Accelerator.إذا كنت ترغب فقط في الوصول إلى أجهزة الذكاء الاصطناعي المتخصصة ، فيمكنك استخدام خدمات الحوسبة السحابية من Google أو بدائل أخرى مثل Microsoft Brainwave.